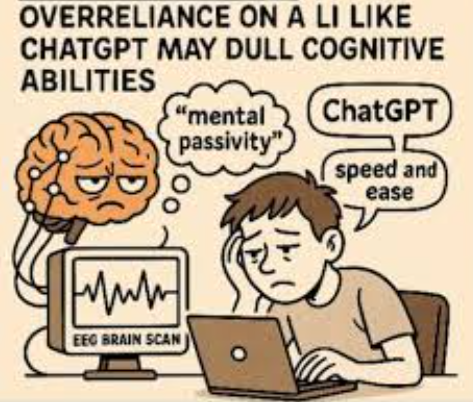

ChatGPT가 알려준 요약만 읽으면 진짜 공부를 한 걸까? 대형 언어모델(이하 LLM)의 폭발적 확산 이후 교육·학습 현장에서 가장 자주 제기되는 질문이다.

복잡한 검색 결과를 일일이 클릭하며 정보를 모을 필요 없이 AI가 척척 요약해주니 편리하기는 하다. 하지만 이 편리함에는 생각보다 큰 대가가 따른다는 연구 결과가 나왔다. 바로 '학습의 깊이'다.

시리 멜루마드(Shiri Melumad) 펜실베이니아대 교수와 윤진호(Jin Ho, Yun) 뉴멕시코주립대 교수 연구팀은 대규모 언어모델(LLM)을 통한 학습이 전통적인 웹 검색보다 지식 습득 깊이를 떨어뜨린다는 실험 증거를 국제학술지 'PNAS Nexus' 최신호에 발표했다.

7개 실험, 1만 462명… LLM 사용자는 덜 배우고, 덜 쓴다

연구진은 온라인과 실험실에서 총 7개의 실험을 진행했다. 10,462명의 참가자들은 무작위로 두 집단으로 나뉘어 한쪽은 구글 검색 결과(웹 링크)를, 다른 쪽은 ChatGPT나 구글의 AI Overview 같은 LLM 요약을 사용해 특정 주제를 학습했다. 주제는 야채 텃밭 가꾸기, 건강한 생활습관, 금융 사기 피해 시 대응법 등 일상과 밀접한 주제들이었다.

학습이 끝난 뒤 모든 참가자는 ‘친구에게 조언하는 글 쓰기’ 과제를 수행했다. 그 과정에서 연구진은 검색 및 학습에 쓴 시간, 참가자 자신이 느낀 학습량과 지식의 소유감, 글의 길이와 사실 및 정보의 풍부함, 글의 유사도와 독창성 등의 항목을 정량적으로 분석했다. 그 결과 ChatGPT를 사용한 그룹은 구글 검색 그룹보다 검색에 투입한 시간이 평균 157초(약 2분 반) 더 짧았다. 빠르고 편리했다는 뜻이다. 하지만 정작 중요한 지표들에서는 모두 뒤처졌다.

ChatGPT 사용자들은 "새로운 것을 배웠다"는 응답 점수가 5점 만점에 3.43점으로, 구글 사용자(3.86점)보다 낮았다. "검색 결과가 포괄적 정보를 제공했다"는 항목에서도 4.02점으로 구글(4.27점)에 미치지 못했다. 더욱이 "내가 얻은 지식에 대한 주인의식"도 3.36점으로 구글(3.55점)보다 낮았다.

멜루마드 교수는 "LLM 요약을 본 사람들은 같은 정보를 접했음에도 덜 배웠다고 느꼈다"면서 “이는 단순히 주관적 느낌이 아니라 그들이 작성한 조언의 질에서도 객관적으로 드러났다."고 설명했다.

실제로 자연어처리(NLP) 분석 결과 ChatGPT 사용자들이 쓴 조언은 평균 84.58단어로 구글 사용자(94.64단어)보다 짧았고, 구체적 사실 언급도 적었다.

더 큰 문제는 독창성이었다. 같은 조건의 참가자들끼리 쓴 글을 비교했을 때, ChatGPT 그룹의 조언들은 서로 훨씬 비슷했다. 주제 유사도 점수는 0.159로, 구글 그룹(0.057)보다 약 3배 높았다. 즉, 자신만의 표현과 해석이 적고 판에 박힌 내용이었다는 뜻이다.

'요약'이 가져온 인지적 편안함, 대가는 ‘얕은 지식’

왜 이런 결과가 나온 걸까. 연구팀이 주목한 핵심은 '학습 과정'의 차이다.

전통적인 웹 검색은 사용자가 여러 링크를 클릭하고, 각 웹사이트의 정보를 읽고, 그것들을 머릿속에서 종합하는 과정을 요구한다. 이 과정은 번거롭지만, 바로 그 '번거로움'이 깊은 학습을 만든다는 것이다.

윤 교수는 "웹 검색은 사용자가 정보를 발견하고, 해석하고, 통합하는 능동적 활동을 하게 함으로써 지식 구조를 더 깊고 독창적으로 만든다. 반면 LLM은 이 종합 과정을 대신 해주므로 사용자는 결과만 받아보게 된다."고 설명했다.

연구진은 바로 이 “편안함”이 문제라고 지적한다. 심리학에서는 어느 정도의 어려움과 노력이 오히려 학습을 깊게 만든다는 ‘바람직한 어려움(desirable difficulty)’ 효과가 널리 알려져 있다. 여러 자료를 비교하고, 모순을 조정하고, 스스로 구조를 짜보는 과정이 장기 기억과 이해도를 높인다는 것이다. LLM은 이 의미 구성 과정을 상당 부분 대신해 주는 만큼, 장점과 함께 깊은 학습을 잠식할 위험도 안고 있다.

편리함과 학습, 균형이 필요하다

한편, 연구팀은 이 결과가 LLM의 모든 사용을 부정하는 것은 아니라고 선을 그었다. LLM은 사실 확인, 개념 인트로, 초안 작성, 코드 예시 생성 등에서 이미 탁월한 효율을 보여주고 있다. 일부 교육 연구에서는 외국어 글쓰기나 기초 코딩 학습에서 LLM이 학습 성취를 높여준다는 결과도 보고된다. 다만 문제는 깊이 있는 절차적 지식, 즉 '어떻게 작동하는지' 이해하고 새로운 지식을 창출하는 능력을 키우는 데는 적합하지 않다는 점이다.

윤 교수는 "LLM은 분명 강력한 도구지만 학습에서 능동성을 수동성으로 바꾸는 위험이 있다"고 지적했다. 그는 "특히 젊은 세대가 LLM에만 의존하면 능동적으로 정보를 탐색하고 종합하는 능력이 퇴화할 수 있다."고 강조했다.

멜루마드 교수 역시 "LLM이 교육과 훈련에 상당한 이점을 가져올 수 있지만, 과도한 의존의 위험을 인식하고 경계해야 한다.”면서 때로는 ChatGPT나 구글이 '구글링을 대신하도록' 내버려두지 않는 것이 더 나을 수 있다고 조언했다.

- 김현정 리포터

- vegastar0707@gmail.com

- 저작권자 2025-12-16 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터