컴퓨터에 대한 해박한 지식을 갖고 시스템을 자유자재로 조작해낼 수 있는 사람을 해커(hacker)라고 한다.

보통 해커를 화이트 해커와 블랙 해커로 구분한다. 선한 마음을 품고 네티즌들에게 이로운 일을 할 경우 화이트 해커라고 칭하고, 반대로 해로운 일을 행할 경우 블랙 해커라고 하는데 최근 블랙 해커로 인한 피해가 심각한 상황이다.

공공기관이나 기업, 단체로부터 정보를 탈취하려는 온라인 공격이 끊이지 않고 있는 가운데 지난 3월에는 사우디 아라비아의 한 석유화학에 대참사를 유발할 수 있는 악성 코드 ‘트리톤’이 발견돼 세계적으로 큰 충격을 주었다.

해커 공격 차단할 학습 방안 찾아내

15일 ‘사이언스’ 지에 따르면 IT 관계자들은 블랙 해커들의 수법이 지금처럼 발전할 경우 인공지능(AI)에 큰 위협이 될 것으로 보고 있다.

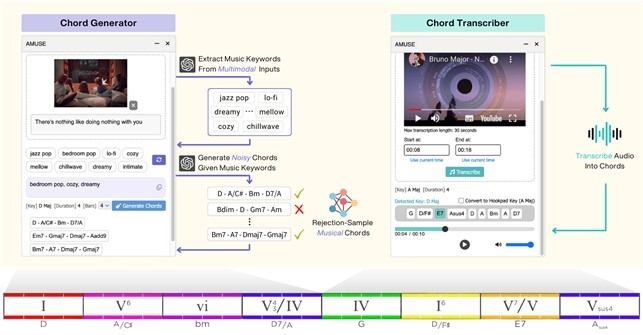

인공지능 비서 ‘알렉사(Alexa)’가 음악을 스트리밍 받는 과정에서 바이러스가 침투해 은행, 신용카드 계좌로부터 돈을 빼가고, 자율주행차가 속도계를 잘못 해석하게 해 심각한 사고를 유발할 수 있다는 것.

그러나 최근 이 문제가 해결되고 있다.

지난주 미국 뉴올리언스에서 열린 세계적인 딥러닝 국제콘퍼런스 ‘ICLR(International Conference on Learning Representations)’에서 AI 연구자들을 통해 해커들의 공격을 막아낼 수 있는 방안이 공개됐다.

이는 머신러닝(machine learning)과 같은 고도화된 AI에게 치명적인 오류를 불러일으킬 수 있는 해커 공격을 더 뛰어난 분석 능력으로 차단해나갈 수 있는 방법이다.

MIT의 컴퓨터과학자 앤드류 일리아스(Andrew Ilyas) 교수는 “해커들의 공격을 방어하려는 기존의 방식이 매우 느리고 서툴렀다”며, “이번에 개발한 방식은 매우 미묘해 어떤 해커들의 기계조작도 뚫고 들어가지 못하도록 구성돼 있다”고 설명했다.

일이아스 교수 연구팀이 훈련된 알고리즘을 대상으로 가상의 해커 공격을 시도한 결과 전체 공격의 약 50% 선에서 방어가 이루어졌다. 이는 이전의 공격에서 95%의 피해를 본 것과 비교해 45% 포인트가 감소한 것이다.

이번 보고서를 접한 일리노이 대학 컴퓨터과학자 보 리(Bo Li) 교수는 “이번 MIT 연구 결과가 매우 강력하면서 유용한 방안을 제시하고 있다”며, “향후 AI에 대한 해커 공격을 차단할 수 있는 적절한 방안으로 평가받고 있다”고 말했다.

특수 이미지 학습 통해 스푸핑 차단

최근 인공지능이 확산되고 있는 가운데 그중에서도 가장 각광을 받는 것이 기계학습이라고 번역되는 머신러닝이다.

컴퓨터를 학습시켜 활용할 수 있는 이 알고리즘은 이세돌과의 바둑 대결을 승리로 이끈 ‘알파고(AlphaGo)’를 통해 익히 알려진 바 있다. 이세돌 이후 알파고를 이길 수 있는 바둑기사가 나오지 않자 개발업체인 구글의 딥마인드는 알고리즘을 폐쇄한 상태다.

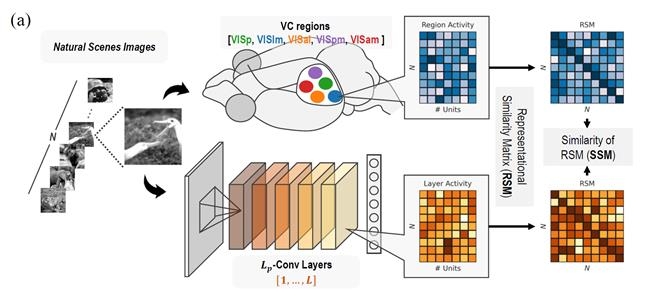

문제는 절대 강자로 보이는 머신 러닝 알고리즘에 치명적인 약점이 있다는 것이다. 어떤 이미지를 시각적으로 잘못 보는 착시(錯視) 현상을 말한다.

그동안 AI 전문가들은 머신러닝의 이런 약점을 해커들이 공격할 경우 심각한 사태가 발생할 수 있다며, 큰 우려를 제기해왔다. 실제로 지난해 ‘ICLR’에서 가상의 해커 공격을 받은 딥러닝이 거북이를 총으로, 야구공을 에스프레소 커피로 보는 착시 현상을 확인한 바 있다.

딥러닝의 착시 현상을 확인한 관계자들은 이런 착시 현상이 해커들로 인해 사이트 주인이 바뀌는 스푸핑(spoofing)을 초래할 수 있다며 걱정해왔다.

스푸핑이란 해커가 남의 사이트에 들어가 임의로 웹사이트를 구성한 다음 프로토콜의 구조적 결함을 이용해 사용자 권한을 획득하고 주인 행세를 하는 해킹 수법을 말한다. 이 악의적인 해킹이 성공을 거둘 경우 사용자들에게 엄청난 해를 가할 수 있다.

딥러닝 전문가들은 해커들이 이 착시 현상을 노려 ‘적대적 공격(Adversarial Attack)’을 해올 경우 속수무책이라는 점을 인정하고 있었다.

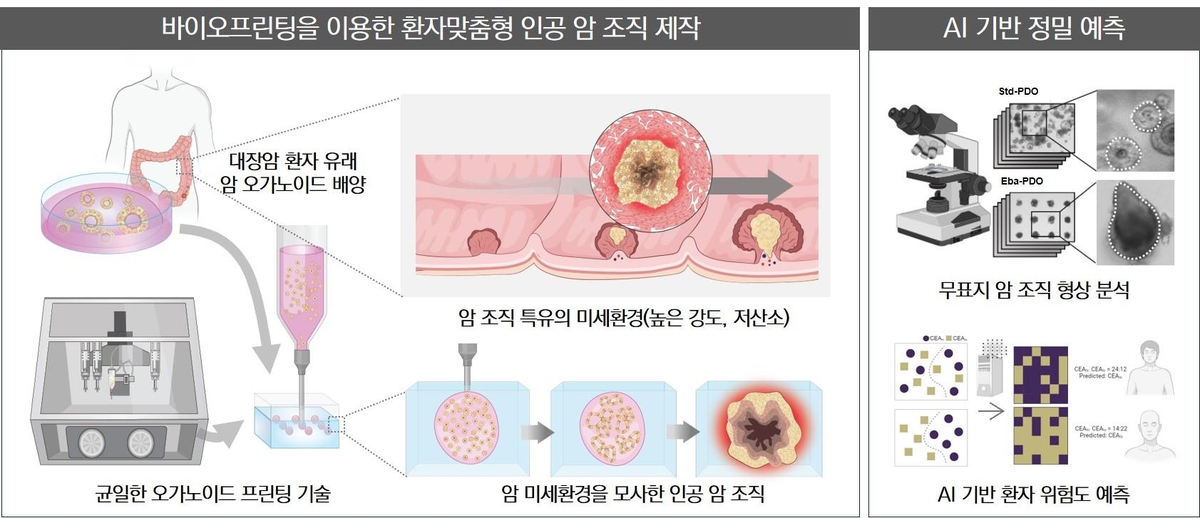

또한 머신러닝이 투입되고 있는 무인자율주행차, 은행의 전자거래, 다양한 매스미디어의 영상인식 과정, 의료계의 영상 분석을 통한 시술 등 실수가 용납되지 않는 분야에서 치명적인 사태가 발생할 수 있을 것으로 보고 있었다.

심지어 인공지능 비서인 ‘알렉스’에 스트리밍 음악을 전송하면서 딥러닝을 조작할 수 있는 바이러스를 주입할 경우 연결된 은행 계좌를 통해 타의적 인출이 가능해지고, 상거래 전반에 심각한 혼란을 초래할 수 있다고 판단하고 있었다.

이런 상황에서 딥러닝의 취약점을 보강하기 위한 방안이 모색됐고, MIT 연구진을 통해 그 실마리가 풀리는 형국이다.

MIT 연구진은 딥러닝의 약점을 극복하기 위해 특별히 제작된 데이터를 적용해 학습을 진행한 것으로 알려졌다.

사람에게는 하나의 사물로 보이지만 컴퓨터에게는 둘 이상의 사물로 보이는 사물들을 이미지화해 컴퓨터에게 그 내용을 정확히 식별할 수 있도록 반복 학습을 시도했다. 이를테면 고양이를 닮은 개 이미지를 제시하고 그 그림이 개인지 고양이인지 식별하게 하는 방식이다.

처음에는 컴퓨터 내부에서 큰 혼란이 일어났다. 그러나 시간이 지나면서 개와 고양이 사이의 미묘한 차이를 인식하기 시작했고, 얼마 후에는 아무리 닮은 형상이라도 그 차이를 정확히 구분할 수 있었다.

논문 공동저자인 MIT의 디미트리스 치프라스(Dimitris Tsipras) 교수는 “학습 데이터를 어떻게 프로그래밍하느냐에 따라 머신러닝의 착시 현상이 발전을 거듭했다”며, “향후 해커 공경에 대비하기 위해 이 방식을 활용해줄 것”을 조언했다.

- 이강봉 객원기자

- aacc409@naver.com

- 저작권자 2019-05-15 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터