한국과학기술원(KAIST)은 그래픽처리장치(GPU)에만 의존하지 않고 다양한 인공지능(AI) 가속기를 통합해 챗GPT와 같은 거대언어모델(LLM)을 효율적으로 서비스할 수 있는 차세대 AI 인프라 소프트웨어를 개발했다고 30일 밝혔다.

전산학부 박종세 교수를 중심으로 한 애니브릿지 AI 팀이 개발한 해당 기술은 카카오가 주최한 '4대 과학기술원×카카오 AI 육성 프로젝트'에서 대상을 받았다.

현재 대부분 LLM 서비스는 고가의 GPU 인프라에 의존하면서 서비스 규모를 확대할수록 운영 비용과 전력 소모가 급격히 증가하는 구조적 한계를 안고 있다.

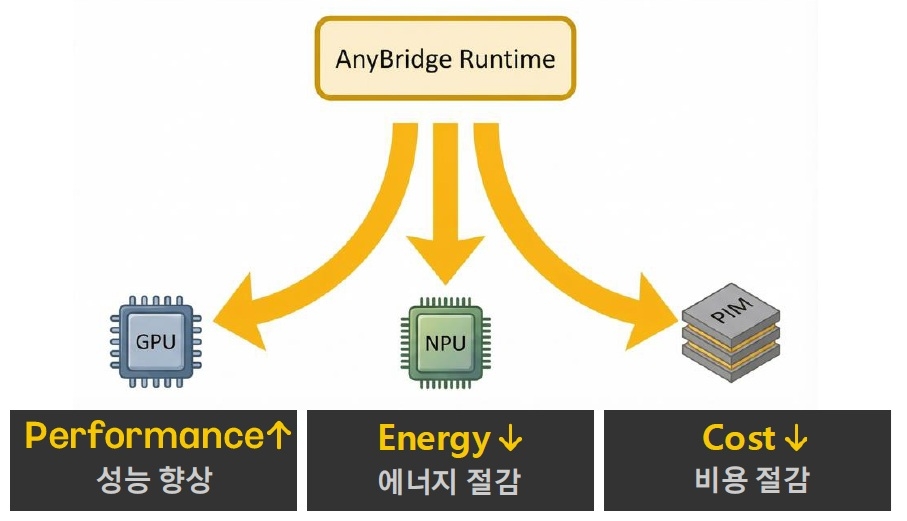

애니브릿지 AI 팀은 GPU뿐만 아니라 NPU(AI 계산에 특화된 반도체), PIM(메모리 안에서 AI 연산을 처리하는 차세대 반도체) 등 다양한 AI 가속기를 효율적으로 통합 연결·운용할 수 있는 '멀티 가속기 LLM 서빙 런타임 소프트웨어'를 해결책으로 제시했다.

해당 기술을 통해 작업 특성에 따라 가장 적합한 AI 가속기를 선택·조합할 수 있는 유연한 AI 인프라 구조를 구현해 냈다.

이는 LLM 서비스의 비용과 전력 소모를 줄이고, 확장성을 높일 수 있는 장점으로 평가된다고 연구팀은 설명했다.

박종세 교수는 "이번 수상은 GPU 중심 AI 인프라의 한계를 넘어 다양한 AI 가속기를 통합하는 시스템 소프트웨어의 필요성을 인정받은 결과"라며 "산업 파트너들과 협력을 통해 차세대 LLM 서빙 인프라 핵심 기술로 발전시켜 나가겠다"고 말했다.

- 연합뉴스

- 저작권자 2026-02-02 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터