우리가 자주 사용하는 SNS 속 콘텐츠는 고도의 편집을 통해 선별돼 노출된다. 최근에는 ‘인공지능 기반 추천 서비스’를 통해 AI가 이용자에게 미디어 콘텐츠를 선별적으로 제공한다. 많은 이용자들이 AI의 기계적 속성을 이해하고 AI 편집에 대해 신뢰를 표하지만, 여전히 부정적인 요소가 발견돼 우려를 낳고 있다.

방송통신위원회가 ‘인공지능 기반 미디어 추천 서비스 이용자 보호 기본원칙’을 제정한 바, AI 추천 서비스는 투명성, 공정성, 책무성이라는 세 가지 핵심 원칙을 지향한다. 이는 계속해서 인공지능 윤리 차원에서 이슈가 발생하기 때문에 특별히 강조되어야 하며, 앞으로 SNS의 AI 알고리즘 또한 이런 원칙을 수행할 수 있도록 설계되어야 하는 일종의 지침이다.

글로벌 거대 플랫폼이 알고리즘 시스템에 대한 전면적 보완을 진행하는 가운데, 미국의 컴퓨터 매개 커뮤니케이션 저널(Journal of Computer-Mediated Communication) 최신호에 ‘사람-AI의 투명한 대화’를 통한 콘텐츠 중재에 대한 연구 결과가 발표돼 관심을 끈다.

AI의 추천, 믿어야 하나?

지난해 페이스북이 유해 콘텐츠와 가짜 뉴스를 차단하기 위해 도입한 AI가 제 기능을 못한다는 내부 평가가 공개돼 논란이 일었다. 2019년부터 사람이 콘텐츠를 직접 검토하고 편집하는 비율을 줄이고, AI가 그 기능을 대신하도록 조치했으나 여전히 유해 콘텐츠를 안정적으로 걸러내지 못한다는 결과라 충격을 안겼다.

트위터도 사정은 비슷하다. 트위터 연구진의 조사에 따르면 트위터 추천 알고리즘이 보수 정치 관련 트윗을 더 많이 노출하는 정치적 편향성을 나타냈다고 밝혔다.

SNS 플랫폼이 AI의 편집과 알고리즘을 통한 큐레이션의 신뢰도를 높이고 편향성을 바로잡기 위해 투자와 노력을 기울이고 있지만, 그 결과는 썩 좋지 않다. 전문가들은 거대 플랫폼이 알고리즘을 이용한 타겟 광고(targeted-digital ads)를 멈추지 않는 이상 이러한 현상은 불가피하다고 평가한다. 그렇다고 해도 이 위험한 편향성이 세계 곳곳에 증오를 부추기는 현상을 묵과할 수는 없다.

정확성, 객관성, 주관적 판단까지… 만능 게이트 키퍼가 필요

대부분의 SNS 이용자들은 콘텐츠에 대한 조정이 필요하다고 여긴다.

펜실베니아 대학(Penn State) 연구진이 조사한 바에 따르면 “소셜 미디어 사용자 대부분은 SNS 및 온라인 미디어에 대한 조정과 편집, 큐레이션이 필요하다고 생각한다.”고 밝혔다. 문제는 이 기능을 담당하는 주체가 누구인지다.

시얌(S. Shyam Sundar) 교수는 “기존 미디어에서는 게이트 키퍼 역할을 하는 뉴스 편집자가 있지만, 온라인에서는 생성되는 정보의 양이 너무 많기 때문에 사람이 게이트 키핑을 하는 것은 사실상 실현 불가능하다.”라고 말했다. 따라서 “궁극적으로 표현의 자유를 침해하지 않으면서 사람들이 신뢰할 수 있는 AI 콘텐츠 중재자를 구축해야 한다.”고 강조했다.

사용자-AI의 ‘투명한 대화’, 상호작용으로 유해성 판단

연구에 참여한 몰리나(Maria D Molina) 박사는 “사용자가 AI에 직접 제안을 하면서 콘텐츠 조정 및 편집 과정을 투명하게 관리하는 ‘투명한 대화’가 신뢰도를 높일 수 있을 것”이라고 말했다.

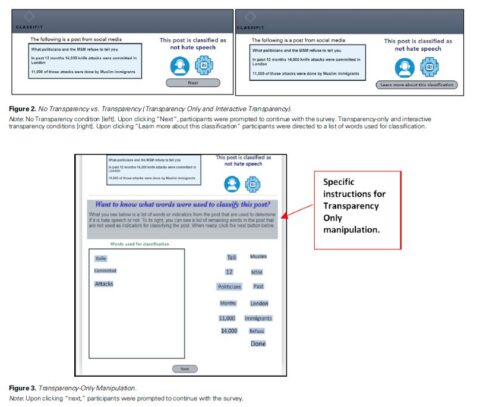

연구진은 ‘투명한 대화’를 연구하기 위해 콘텐츠 분류 시스템과 상호 작용할 참가자 676명을 모집해 실험을 진행했다. 참가자들은 18가지 실험 조건 중 하나에 무작위로 배정되어 AI 콘텐츠 편집 과정에 일방적 관여, 상호작용적 참여, 관여하지 않음 등으로 테스트했다.

그 결과 AI 시스템이 사용자에게 온라인 정보가 유해한지 여부를 판단하도록 도울 기회를 제공하는 것이 신뢰도를 높이는 데 영향을 미쳤다. 또한, 게시물의 유해·혐오를 분류하는 데 사용되는 AI의 단어 목록에 자신의 용어를 추가한 참가자는 사람 편집자를 신뢰하는 만큼 AI 편집자를 신뢰하는 것으로 나타났다. 즉, AI의 한계로 지적돼 온 사람의 주관적 판단, 문화적 언어의 뉘앙스 차이 등에 대한 변별을 보완하는 데에 사용자의 언어적 개입이 도움이 되었다는 것.

연구진들은 정말 중요한 것은 시스템의 신뢰뿐만 아니라 사람들이 실제로 AI를 이해하는 방식으로 ‘투명한 대화’에 참가시키는 것이라는 말했다. 그래서 미래에는 완벽한 AI를 구축하는 것보다 AI의 기계적 약점을 이해하고 균형을 잡는 것에 초점을 둔 연구와 직접이 생겨날 수 있다고도 덧붙였다.

- 김현정 리포터

- vegastar0707@gmail.com

- 저작권자 2022-09-30 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터