지난 2월 개설된 'Which Face Is Real?'이라는 웹사이트에 접속하면 한 쌍의 얼굴 사진이 나온다. 그중에 하나는 인공지능을 사용해서 만든 가짜 얼굴이다. 접속자는 어느 것이 진짜인지를 게임 방식으로 선택할 수 있다. 지금까지 이 사이트에 약 50만 명이 방문해서 600만 회 가까운 플레이 횟수를 기록했다.

WhichFaceIsReal.com은 워싱턴 대학의 제빈 웨스트(Jevin West), 칼 버그스트롬(Carl Bergstrom) 교수가 제작했다. 최근 범람하는 AI 기술을 이용한 가짜 영상, 사진의 위험성을 경고하는 것이 목적이다. 제작자들은 ‘더 버지(The Verge)’와의 인터뷰에서 “새로운 기술이 등장했지만, 대중이 그것을 인식하지 못할 때가 위험한 시기이다. 우리는 교육을 통해서 이러한 기술이 있다는 사실을 알리고 싶다”라고 밝혔다.

딥러닝으로 가짜 얼굴 만들어

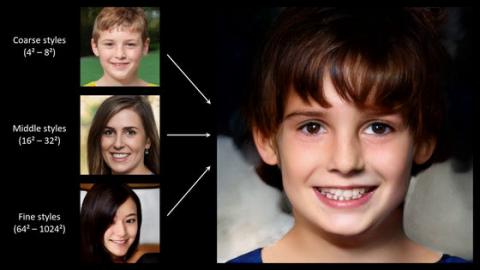

2014년 이안 굿펠로우(Ian Goodfellow)라는 AI 기술자가 캐나다 몬트리올의 선술집에서 동료들과 토론을 하다가 어떤 아이디어를 떠올렸다. 이것을 바탕으로 탄생한 혁신적인 기술이 ‘생성적 적대 네트워크(Generative Adversarial Network, GAN)’였다. GAN은 두 개의 신경망 네트워크로 구성된 딥러닝 이미지 생성 알고리즘이다. 생성자(generator)는 가짜 이미지를 생성하여 컬렉션에 추가하고, 감별자(discriminator)는 진위를 판별하게 된다. 그런 적대 관계 속에서 공방전을 계속 반복하면 가짜 이미지의 정밀도가 점점 올라가는 것이다.

WhichFaceIsReal에 나오는 가짜 사진은 GPU 업체 엔비디아(NVIDIA)가 개발한 ‘StyleGAN’을 활용해서 만들어졌다. 제작진은 GAN 알고리즘을 기반으로 하는 공개 소프트웨어인 StyleGAN을 사용해서 가짜 이미지를 합성했다.

지난 2월 오픈 소스로 발표된 StyleGAN은 놀라운 성능으로 화제를 모았다. 이전까지 GAN을 기반으로 한 이미지 합성 기술은 BEGAN, PGGAN 등을 거치며 눈부신 발전을 거듭했지만, 생성된 이미지가 약간 어색한 편이었다. StyleGAN은 기존 소프트웨어와 비교하면 완성도가 매우 높다.

엔비디아는 오랜 학습 과정을 거치지 않고 바로 얼굴을 생성할 수 있도록 GAN 코드 이외에도 신경망 웨이트 형태로 교육이 끝난 모델을 공개했다. 수천 명의 유명인과 ‘플리커(Flickr)’에 공개된 7만 명의 얼굴 사진을 미리 학습한 것이다. 이를 통해서 WhichFaceIsReal 제작진은 일주일 만에 수천 개의 가짜 얼굴을 생성할 수 있었다.

가짜 이미지를 구별하기 어려워져

아직까지 가짜 이미지 생성 기술은 완전하지 않다. StyleGAN은 인체의 해부학적 구조를 이해하지 못하며, 배경이나 귀걸이를 생성하는 데 어려움을 겪고 있다. 그럼에도 불구하고 가짜 이미지를 분별하는 데 한계가 있다. WhichFaceIsReal에 처음 접속한 사람이 진짜를 식별하는 비율은 평균 60%가량이었지만, 게임을 거듭해도 이 비율은 약 75%에서 더 이상 올라가지 못했다.

웨스트 교수는 관련 기술이 빠르게 발전하고 있어서 앞으로 3년 안에 가짜 이미지를 인간이 구별하지 못할 것으로 예측했다. 그러나 사람이 가짜 이미지에 속는 과정을 연구하면 식별 소프트웨어를 개발할 수 있을지도 모른다. 연구팀은 앞으로 가짜 얼굴에 반응하는 사람의 안구 움직임을 추적하는 연구를 진행할 계획이다.

StyleGAN은 이미 각국의 첩보 활동에 사용되는 것으로 알려졌다. 버그스트롬 교수는 “구글 이미지 추적으로 테러 용의자를 식별해낼 수 있겠지만, AI가 만들어낸 가짜 이미지가 추가되면 수사 난이도가 올라갈 것이다”라고 말했다. 두 연구자는 AI 기술의 테러 이용 가능성에 큰 우려를 표명하면서 많은 연구자가 ‘딥페이크(Deepfake)’를 추적하기 위해 노력 중이라고 밝혔다.

- 심창섭 객원기자

- chsshim@naver.com

- 저작권자 2019-07-31 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터