영국의 한 유명 대학에서 실시된 실험에서 생성형 인공지능(AI) 챗GPT-4가 작성한 답안의 94%가 숙련된 채점자들에게 적발되지 않았고 83%는 실제 학생의 답안보다 더 높은 점수를 받은 것으로 나타났다.

영국 레딩대 심리·임상언어과학대학 피터 스카프 교수팀은 27일 과학 저널 플로스 ONE(PLoS ONE)에서 이 대학 실제 학부 시험에 AI 작성 답안을 제출하는 엄격한 블라인드 방식 실험에서 이런 결과를 얻었다고 밝혔다.

연구팀은 이 연구는 지금까지 인간 교육자가 AI 생성 콘텐츠를 구별할 수 있는지 알아보는 실험 중 가장 크고 강력한 블라인드 실험이라며 이 결과는 AI가 대학 시험에서도 컴퓨터(인공지능)와 인간을 구별해내는 튜링 테스트(Turing Test)를 통과했음을 보여준다고 말했다.

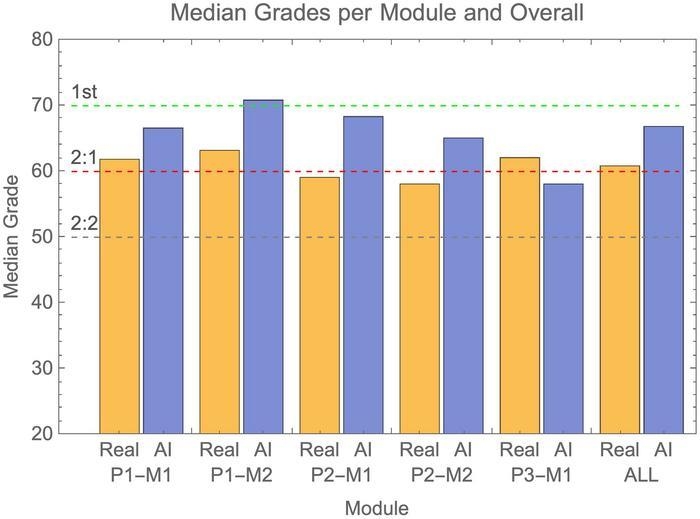

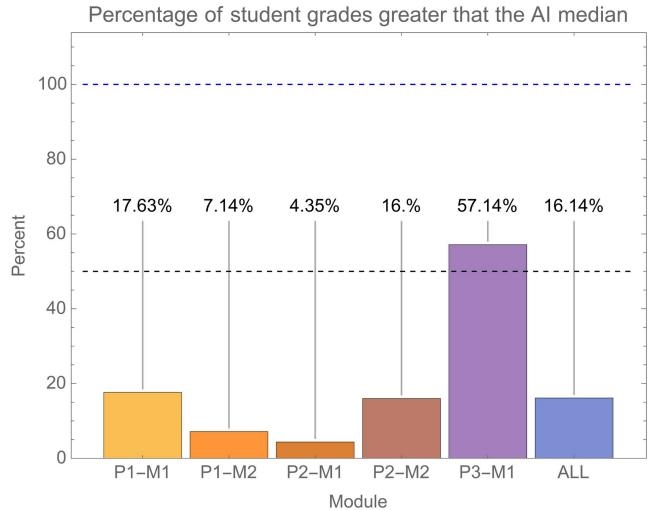

그 결과 AI가 작성한 답안의 94%가 채점자들에게 적발되지 않았고, 평균적으로 실제 학생의 답안보다 더 높은 점수를 받은 것으로 나타났다. AI가 작성한 답안과 실제 학생 답안을 무작위로 선택해 비교할 경우 AI 답안이 점수가 높을 확률이 83.4%에 달했다. 또 실제 학생이 AI 점수 중간값보다 높은 점수를 받는 비율은 4개 시험에서 4.35~17.63%에 불과했고, 에세이 시험 중 1개에서만 실제 학생 57.14%의 점수가 AI 점수 중간값을 넘었다.

연구팀은 이 결과는 학생들이 부정행위에 AI를 사용할 수 있고 이들이 다른 학생보다 더 좋은 성적을 받을 가능성을 시사한다며 연구 과정에서 실제 학생 중 상당수가 AI 생성 제출물을 통해 부정행위를 했을 가능성도 고려하고 있다고 말했다. 이어 이 결과는 AI가 교육 평가에 어떤 영향을 미칠 수 있는지 보여주는 것으로 매우 우려스럽다며 전 세계 교육 부문이 AI 발달에 대응해 새로운 정책과 지침을 만들어 문제 해결을 위해 더 많은 노력을 기울여야 한다고 강조했다.

◆ 출처 : PLoS ONE, Peter Scarfe et al., 'A real-world test of artificial intelligence infiltration of a university examinations system: A "Turing Test" case study', https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0305354

- 연합뉴스

- 저작권자 2024-07-02 ⓒ ScienceTimes

관련기사

뉴스레터

뉴스레터